Файл robots.txt помогает основным поисковым системам понять, где им разрешено переходить по вашему сайту. Хотя основные поисковые системы действительно поддерживают файл robots.txt, не все они могут придерживаться правил одинаково.

Ниже давайте разберемся, что такое файл robots.txt и как его использовать.

Что такое robots.txt?

Каждый день на ваш сайт заходят боты, также известные как роботы или пауки. Поисковые системы, такие как Google и Яндекс, отправляют этих ботов на ваш сайт, чтобы ваш контент можно было сканировать, индексировать и отображать в результатах поиска.

Боты — это хорошо, но в некоторых случаях вы не хотите, чтобы бот бегал по вашему сайту, сканируя и индексируя все. Вот тут-то и пригодится файл robots.txt. Добавляя определенные директивы в файл robots.txt, вы предписываете ботам сканировать только те страницы, которые вы хотите просканировать.

Однако важно понимать, что не каждый бот будет придерживаться правил, которые вы укажете в файле robots.txt. Google, например, не будет слушать никакие директивы, которые вы помещаете в файл о частоте сканирования.

Для чего нужен robots.txt и нужен ли он вообще?

Для сайта файл robots.txt не требуется. Если бот приходит на ваш сайт, а у него его нет, он просто просканирует ваш сайт и проиндексирует страницы, как обычно. Файл robot.txt нужен только в том случае, если вы хотите иметь больший контроль над тем, что сканируется.

Некоторые преимущества наличия файла:

- Помогает справиться с перегрузкой сервера.

- Предотвращение сканирование нежелательных страниц.

- Сохраняет конфиденциальность определенных папок или поддоменов.

Может ли файл robots.txt предотвратить индексацию контента?

Нет, вы не можете запретить индексирование контента и его отображение в результатах поиска с помощью файла robots.txt. Не все роботы будут следовать инструкциям одинаково, поэтому некоторые могут индексировать контент, который вы специально закрывали от индексации.

Кроме того, если контент, который вы пытаетесь предотвратить от показа в поисковике, имеет внешние ссылки, это также заставит поисковые системы проиндексировать страницу.

Единственный способ гарантировать, что ваш контент не будет проиндексирован, — это добавить на страницу метатег noindex. Эта строка кода выглядит так и будет помещена в html вашей страницы.

<meta name = «robots» content = «noindex»>

Где находится файл robots.txt в wordpress?

Файл robots.txt всегда находится в корневом домене веб-сайта. Например, наш собственный файл можно найти по адресу https://www.weratel.com.ua/robots.txt.

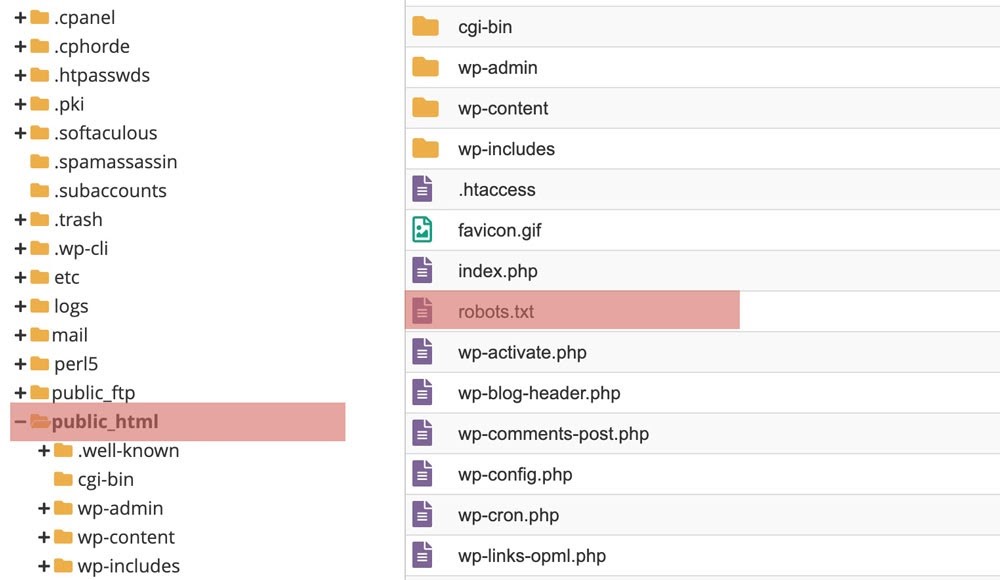

На большинстве сайтов у вас должен быть доступ к фактическому файлу, чтобы вы могли редактировать его по FTP или с помощью диспетчера файлов в CPanel вашего хоста. Если вы используете WordPress, файл robots.txt можно получить в папке public_html вашего веб-сайта.

WordPress по умолчанию включает файл robots.txt с новой установкой, которая будет включать следующее:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Вышеупомянутое говорит всем ботам сканировать все части веб-сайта, кроме всего, что находится в каталогах / wp-admin / или / wp-includes /.

Но вы можете создать более надежный файл. Давайте покажем вам, как это сделать, ниже.

Зачем нужен Robots.txt?

Вы можете настроить файл robots.txt по многим причинам — от управления краул бюджета до блокировки сканирования и индексации разделов веб-сайта. Сейчас ознакомимся с несколькими причинами использования файла robots.txt.

1. Блокировка всех crawl-ботов

Блокировка доступа всех поисковых роботов к вашему сайту — это не то, что вы хотели бы делать на активном веб-сайте, но это отличный вариант сайта на стадии разработки. Когда вы блокируете поисковых роботов, это помогает предотвратить отображение ваших страниц в поисковых системах, что хорошо, если ваши страницы еще не готовы к просмотру.

2. Запрет на сканирования конкретных страниц

Один из наиболее распространенных и полезных способов использования файла robots.txt — ограничить доступ ботов поисковой системы к определенным страницам сайта. Это может помочь максимально увеличить ваш краулинговый бюджет и предотвратить попадание нежелательных страниц в результаты поиска.

Важно уточнить, что то, что вы сказали боту не сканировать страницу, не означает, что она не будет проиндексирована. Если вы не хотите, чтобы страница отображалась в результатах поиска, вам необходимо добавить на страницу метатег noindex.

Примеры директив файла Robots.txt

Файл robots.txt состоит из блоков строк директив. Каждая директива начинается с пользовательского агента, а затем правила для этого пользовательского агента будут помещены под ним. Когда определенная поисковая система попадает на ваш веб-сайт, она будет искать пользовательский агент, который к ней относится, и считывать блок, который ссылается на них.

Есть несколько директив, которые вы можете использовать в своем файле. Давайте разберем их сейчас.

1. User-Agent

Команда user-agent позволяет настроить таргетинг на определенных ботов или пауков. Например, если вы хотите настроить таргетинг только на Yandex или Google, то эта директива будет вам очень полезна.

Хотя существуют сотни пользовательских агентов, ниже приведены примеры некоторых из наиболее распространенных опций пользовательских агентов.

- User-agent: Googlebot

- User-agent: Googlebot-Image

- User-agent: Googlebot-Mobile

- User-agent: Googlebot-News

- User-agent: Bingbot

- User-agent: Baiduspider

- User-agent: msnbot

- User-agent: slurp (Yahoo)

- User-agent: yandex

Важно отметить – User-Agent чувствительный к регистру, поэтому убедитесь, что вводите их правильно.

Wildcard User-agent

Wildcard User-agent знаками отмечен звездочкой (*) и позволяет легко применить директиву ко всем существующим пользовательским агентам. Поэтому, если вы хотите, чтобы к каждому боту применялось определенное правило, вы можете использовать этот пользовательский агент.

User-Agent: *

Пользовательские агенты будут следовать только тем правилам, которые к ним наиболее близко применяются.

2. Disallow

Директива disallow указывает поисковым системам не сканировать и не получать доступ к определенным страницам или каталогам на веб-сайте. Ниже приведены несколько примеров использования директивы disallow.

Блокировать доступ к определенной папке

В этом примере мы говорим всем ботам ничего не сканировать в каталоге / портфолио на нашем веб-сайте.

User-agent: *

Disallow: /portfolio

Если мы хотим, чтобы определенный поисковик не сканировал наше портфолио, то мы воспользуемся следующей директивой:

User-agent: Bingbot

Disallow: /portfolio

Блокировать PDF или другие типы файлов

Если вы не хотите, чтобы ваш PDF-файл или файлы других типов сканировались, вам может помочь следующая директива. Мы сообщаем всем ботам, что не хотим сканировать какие-либо PDF-файлы. Знак $ в конце сообщает поисковой системе, что это конец URL-адреса.

Поэтому, если у меня есть файл pdf на mywebsite.com/site/myimportantinfo.pdf, поисковые системы не получат к нему доступ.

User-agent: *

Disallow: *.pdf$

Для файлов PowerPoint вы можете использовать:

User-agent: *

Disallow: *.ppt$

Лучшим вариантом может быть создание папки для вашего PDF или других файлов, а затем запретить сканерам сканировать ее и не индексировать весь каталог с помощью метатега.

Блокировать доступ ко всему сайту

Эта директива особенно полезна, если у вас сайт находится на этапе разработке или тестирования, поскольку она говорит всем ботам, чтобы они вообще не сканировали ваш сайт. Важно не забыть удалить это во время запуска сайта, иначе у вас возникнут проблемы с индексацией.

User-agent: *

* (Звездочка), которую вы видите выше, — это то, что мы называем выражением «подстановочный знак». Когда мы используем звездочку, мы подразумеваем, что приведенные ниже правила должны применяться ко всем пользовательским агентам.

3. Allow

Директива Allow может помочь вам указать определенные страницы или каталоги, к которым вы хотите, чтобы боты могли получать доступ и сканировать. Это может быть правило переопределения для Disallow директивы, которую вы видели выше.

В приведенном ниже примере мы сообщаем роботу Googlebot, что мы не хотим, чтобы каталог портфолио сканировался, но мы хотим, чтобы был доступен и просканирован один конкретный элемент портфеля:

User-agent: Googlebot

Disallow: /portfolio

Allow: /portfolio/crawlableportfolio

4. Sitemap

Включение местоположения вашего sitemap.xml может облегчить сканерам поисковых систем сканирование вашей карты сайта. Если вы отправляете свой Sitemap непосредственно в инструменты для веб-мастеров каждой поисковой системы, то нет необходимости добавлять их в файл robots.txt.

sitemap: https://yourwebsite.com/sitemap.xml

5. Crawl Delay

Crawl Delay может заставить бота замедлиться при сканировании вашего сайта, чтобы ваш сервер не перегружался. В приведенном ниже примере, директивы Яндекс просят подождать 10 секунд после каждого сканирования сайта.

User-agent: yandex

Crawl-delay: 10

Это директива, с которой вы должны быть осторожны. На очень большом веб-сайте это может значительно уменьшить количество URL-адресов, сканируемых каждый день, что было бы контрпродуктивно. Однако это может быть полезно на небольших веб-сайтах, где боты заходят слишком часто.

Примечание. Задержка сканирования не поддерживается Google и Baidu. Если вы хотите попросить их сканеры замедлить сканирование вашего веб-сайта, вам нужно будет сделать это с помощью их инструментов.

Что такое регулярные выражения и подстановочные знаки?

Сопоставление с шаблоном — это более продвинутый способ управления сканированием вашего веб-сайта ботом с использованием символов. Есть два общих выражения, которые используются как Bing, так и Google. Эти директивы могут быть особенно полезны на сайтах e-commerce.

- Звездочка: * рассматривается как подстановочный знак и может представлять любую последовательность символов.

- Знак доллара: $ используется для обозначения конца URL-адреса.

Хороший пример использования подстановочного знака * — это сценарий, в котором вы хотите запретить поисковым системам сканировать страницы, на которых может быть знак вопроса. В приведенном ниже коде всем ботам предлагается игнорировать сканирование любых URL-адресов, в которых есть вопросительный знак.

User-agent: *

Disallow: /*?

Robots.txt как создать или отредактировать файл

Если у вас нет существующего файла robots.txt на вашем сервере, вы можете легко добавить его, выполнив следующие действия.

- Откройте предпочтительный текстовый редактор, чтобы создать новый документ. Обычные редакторы, которые могут существовать на вашем компьютере, — это Блокнот, TextEdit или Microsoft Word.

- Добавьте директивы, которые вы хотите включить в документ.

- Сохраните файл с именем «robots.txt».

- Проверьте свой файл, как показано в следующем разделе.

- Загрузите файл .txt на свой сервер через FTP или в CPanel. Как вы его загрузите, будет зависеть от типа вашего веб-сайта.

В WordPress вы можете использовать такие плагины, как Yoast, All In One SEO, Rank Math для создания и редактирования файла.

Robots.txt как проверить файл

Прежде чем приступить к работе с кодом файла robots.txt, который вы создали, вам нужно запустить его через тестер, чтобы убедиться, что он рабочий. Это поможет предотвратить проблемы с неправильными директивами, которые могли быть добавлены.

Инструмент тестирования robots.txt доступен только в старой версии Google Search Console. Если ваш веб-сайт не подключен к Google Search Console, вам нужно будет это сделать в первую очередь.

Посетите страницу поддержки Google и нажмите кнопку «открыть тестер robots.txt». Выберите свойство, которое вы хотите проверить. Чтобы протестировать новый код robots.txt, просто удалите то, что сейчас находится в поле, замените новым кодом и нажмите «Проверить». Если ответ на ваш тест «разрешен», значит, ваш код действителен, и вы можете изменить свой фактический файл с новым кодом.

Надеюсь, этот пост заставил вас меньше бояться копаться в файле robots.txt, потому что это один из способов улучшить свой рейтинг и активизировать усилия по поисковой оптимизации. Также у нас есть статья, где подробно рассказываем, как настроить мета-теги и почему они важны!